Inhalt

Quelle: Kran77 / Dreamstime.com

Wegbringen:

Deep-Learning-Modelle bringen Computern das selbständige Denken bei, mit einigen sehr unterhaltsamen und interessanten Ergebnissen.

Deep Learning wird in immer mehr Bereichen und Branchen angewendet. Von fahrerlosen Autos über Go-Spielen bis hin zur Erzeugung von Musikbildern gibt es jeden Tag neue Deep-Learning-Modelle. Hier gehen wir einige populäre Deep Learning Modelle durch. Wissenschaftler und Entwickler nehmen diese Modelle und modifizieren sie auf neue und kreative Weise. Wir hoffen, dass dieses Schaufenster Sie inspirieren kann, zu sehen, was möglich ist. (Informationen zu Fortschritten in der künstlichen Intelligenz finden Sie unter Werden Computer in der Lage sein, das menschliche Gehirn zu imitieren?)

Neuronaler Stil

Sie können Ihre Programmierkenntnisse nicht verbessern, wenn sich niemand um die Softwarequalität kümmert.

Neuronaler Geschichtenerzähler

Der neuronale Geschichtenerzähler ist ein Modell, das bei einem bestimmten Bild eine Liebesgeschichte über das Bild erzeugen kann. Es ist ein lustiges Spielzeug und dennoch können Sie sich die Zukunft vorstellen und sehen, in welche Richtung sich all diese Modelle mit künstlicher Intelligenz bewegen.

Bei der obigen Funktion handelt es sich um die "Stilwechsel" -Operation, mit der das Modell Standard-Bildunterschriften auf den Stil von Romangeschichten übertragen kann. Style Shifting wurde von "A Neural Algorithm of Artistic Style" inspiriert.

Daten

Es gibt zwei Hauptdatenquellen, die in diesem Modell verwendet werden. MSCOCO ist ein Datensatz von Microsoft, der ungefähr 300.000 Bilder enthält, wobei jedes Bild fünf Bildunterschriften enthält. MSCOCO ist die einzige überwachte Daten, die verwendet wird, dh es ist die einzige Daten, bei der Menschen Bildunterschriften für jedes Bild eingeben und explizit ausschreiben mussten.

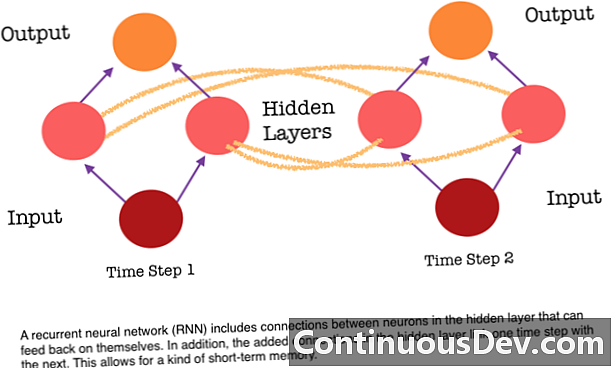

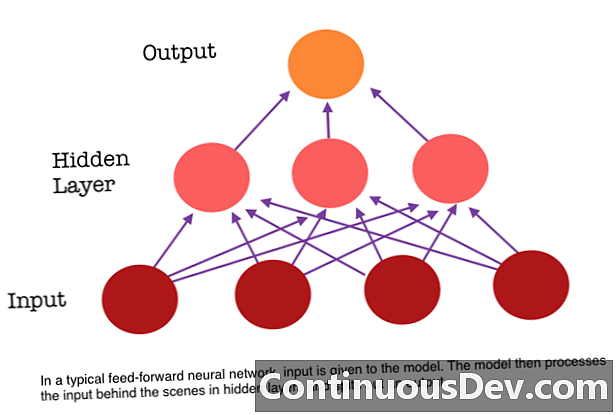

Eine der Haupteinschränkungen eines neuronalen Feed-Forward-Netzwerks besteht darin, dass es keinen Speicher hat. Jede Vorhersage ist unabhängig von vorherigen Berechnungen, als wäre es die erste und einzige Vorhersage, die das Netzwerk jemals gemacht hat. Bei vielen Aufgaben, z. B. beim Übersetzen eines Satzes oder Absatzes, sollten die Eingaben jedoch aus aufeinander folgenden und aufeinander bezogenen Daten bestehen. Zum Beispiel wäre es schwierig, ein einzelnes Wort in einem Satz zu verstehen, ohne die Konstante der umgebenden Wörter.

RNNs sind unterschiedlich, weil sie einen weiteren Satz von Verbindungen zwischen den Neuronen hinzufügen. Über diese Verknüpfungen können die Aktivierungen der Neuronen in einer verborgenen Schicht im nächsten Schritt der Sequenz in sich selbst zurückgeführt werden. Mit anderen Worten, bei jedem Schritt erhält eine verborgene Ebene sowohl die Aktivierung von der darunter liegenden Ebene als auch vom vorherigen Schritt in der Sequenz. Diese Struktur ergibt im wesentlichen einen wiederkehrenden Speicher für neuronale Netze. Für die Aufgabe der Objekterkennung kann ein RNN daher auf seine vorherigen Klassifikationen von Hunden zurückgreifen, um zu bestimmen, ob das aktuelle Bild ein Hund ist.

Char-RNN TED

Diese flexible Struktur in der verborgenen Schicht ermöglicht, dass RNNs für Sprachmodelle auf Zeichenebene sehr gut sind. Char RNN, ursprünglich erstellt von Andrej Karpathy, ist ein Modell, das eine Datei als Eingabe verwendet und eine RNN trainiert, um zu lernen, das nächste Zeichen in einer Sequenz vorherzusagen. Die RNN kann Zeichen für Zeichen generieren, die den ursprünglichen Trainingsdaten entsprechen. Eine Demo wurde mit Transkripten verschiedener TED-Vorträge trainiert. Geben Sie dem Modell ein oder mehrere Schlüsselwörter ein und es wird eine Passage über das / die Schlüsselwörter in der Stimme / dem Stil eines TED-Gesprächs erstellt.

Fazit

Diese Modelle zeigen neue Durchbrüche in der maschinellen Intelligenz, die durch tiefes Lernen möglich wurden. Tiefes Lernen zeigt, dass wir Probleme lösen können, die wir nie zuvor lösen konnten, und dass wir dieses Plateau noch nicht erreicht haben. Erwarten Sie in den nächsten Jahren viele weitere aufregende Dinge, wie fahrerlose Autos, als Ergebnis einer tiefgreifenden lernenden Innovation.